Si la plupart des entreprises « croulent » aujourd’hui sous les données, toutes ne sont pas de valeur égale. C’est la fameuse problématique de la fiabilité des données. Mais qu’est-ce qu’une donnée fiable au juste ? De manière très simple on pourrait définir la donnée fiable comme une info précise, cohérente, opportune, pertinente, intègre, etc. Autrement dit, il s’agit d’une donnée sur laquelle l’entreprise peut compter pour guider ses décisions.

L’importance évidente des données fiables pour la prise de décision, la conformité réglementaire et l’efficacité opérationnelle

Le data-driven est devenu (depuis ~5-10 ans) une sorte de norme dans le monde des entreprises…et pour une bonne raison. Avec des données fiables à portée de main, n’importe quelle entreprise peut prendre des décisions stratégiques basées sur des faits concrets plutôt que sur des suppositions.

En outre, avoir des données fiables est aujourd’hui impératif pour assurer sa conformité réglementaire. Par exemple, la norme ISO/IEC 27000:2018 exige que les organisations mettent en place des systèmes de gestion de la sécurité de l’information (SMSI) pour protéger leurs données sensibles.

Aussi, et de manière plus globale, des données fiables améliorent l’efficacité opérationnelle en éliminant les erreurs et les incohérences qui peuvent entraîner des retards et des inefficacités…

Les critères qui définissent les données fiables

Les données fiables doivent satisfaire à 5 critères :

- Tout d’abord, elles doivent être…exactes ! Eh oui ça peut paraître tout bête mais la première chose à laquelle il faut faire attention. Cela signifie qu’elles ne doivent pas comporter d’erreurs et doivent refléter fidèlement la réalité.

- Cohérentes : elles doivent être harmonisées dans le temps et entre les différentes sources de données.

- Opportunes : elles doivent être disponibles lorsque vous en avez besoin.

- Pertinentes : elles doivent être pertinentes pour le problème ou la décision à prendre.

- Intègres : elles doivent être protégées contre la corruption, la modification ou la destruction non autorisées.

Mais pourquoi au juste est-il si compliqué d’obtenir ces données fiables ?

Pourquoi l’obtention de données fiables est-elle si compliquée ?

Alors bien entendu, avoir des données fiables n’est pas une tâche facile. Il existe une multitude d’obstacles à surmonter, à commencer par la garantie de l’exactitude des données. Une seule erreur peut avoir des conséquences potentielles critiques pour l’entreprise, allant de la prise de mauvaises décisions à la non-conformité réglementaire.

Le volume de données à gérer est également un piège auquel il faut faire attention. Avec l’avènement du Cloud et du Big Data, les entreprises sont submergées par des volumes de données sans précédent, ce qui rend leur gestion d’autant plus difficile.

Vient ensuite le fameux défi de garantir la cohérence des données. De mauvaises données peuvent entraîner une confusion et des erreurs, ce qui peut à son tour nuire à l’efficacité opérationnelle de l’entreprise.

Et la complexité des données, on en parle ? Elles proviennent généralement de sources diverses et sont stockées dans différents formats, ce qui rend leur consolidation et leur normalisation difficiles.

Enfin il y a la rapidité avec laquelle les données évoluent, ce qui rend leur mise à jour et leur maintenance d’autant plus délicates. L’équipe marketing qui peste après les commerciaux qui n’ont pas mis à jour les données clients dans la CRM, ça vous parle (j’avoue, j’en parle souvent) ? J’ai planté un paquet de campagnes emailings à cause de ça 🙄…

Les fondements pour assurer la fiabilité des données

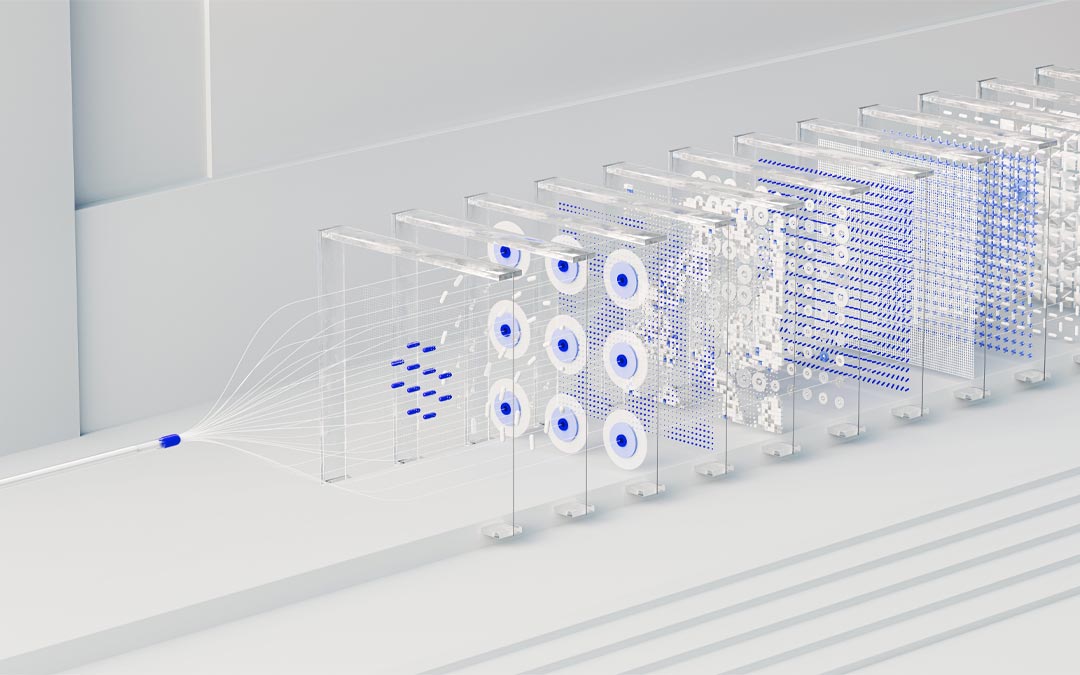

Pour surmonter ces obstacles, il est nécessaire de mettre en place quatre piliers : la gouvernance des données, la gestion des données, la supervision des données, et les outils de consolidation des données.

- La gouvernance des données implique la mise en place de politiques, de procédures et de responsabilités pour assurer la gestion efficace des données. Les rôles clés dans la gouvernance des données sont le Data Steward (responsable de la qualité des données et de leur conformité aux normes et aux réglementations) et le Data Owner (responsable de l’exactitude, de la cohérence, de l’opportunité, de la pertinence, et de l’intégrité des données).

- La gestion des données implique la mise en place de systèmes et de technologies pour assurer la sécurité et la confidentialité des données. Elle est pilotée par le Data Manager (responsable de la mise en œuvre des politiques et des procédures de gestion des données) et le Data Administrator (responsable de l’administration des systèmes et des technologies de gestion des données).

- La supervision des données concerne la mise en place de mécanismes de surveillance et d’évaluation pour détecter et corriger les erreurs et les incohérences dans les données. C’est le travail du Data Auditor (responsable de l’audit de la qualité des données et de leur conformité aux normes et aux réglementations) et du Data Analyst (responsable de l’analyse des données pour en déduire des informations et des connaissances).

- Enfin, les outils de consolidation des données permettent de rassembler des données provenant de sources diverses et de les combiner en un seul ensemble cohérent et intégré. On parle ici de systèmes de gestion de bases de données (DBMS), de Data Warehouses, de Data Lakes, ou de Data Platforms. Par exemple, des solutions comme Phoenix de Blueway participent à la fiabilité des données au sein du système d’information.

En clair, retenez qu’une donnée obsolète, incohérente, inexacte peut être aussi néfaste pour une organisation qu’une donnée fiable peut lui être précieuse. Donc prenez le sujet au sérieux avant qu’il ne soit trop et que vous soyez dépassez (ça peut aller très vite !), votre activité vous en remerciera…